Что такое информация в математике

Содержимое

- 1 Что такое информация в математике

- 1.1 Основные понятия и принципы информации в математике

- 1.2 Видео по теме:

- 1.3 Понятие информации в математике

- 1.4 Математический анализ информации

- 1.5 Вопрос-ответ:

- 1.6 Информационная энтропия

- 1.7 Информационная емкость

- 1.8 Информационная структура

- 1.9 Принципы информационной теории

- 1.10 Связь информации и вероятности

- 1.11 Применение информации в математике и других областях

Информация в математике – это числовые данные, факты или знания, которые могут быть представлены и обработаны с использованием математических методов и моделей. В математике информация может быть представлена в виде числовых значений, формул, графиков или символов. Она играет важную роль в различных областях математики, таких как теория вероятности, статистика, теория информации и криптография.

Информация – это одно из фундаментальных понятий, которое активно используется в математике. В современном мире информация играет важную роль в различных сферах жизни, начиная от науки и технологий, и заканчивая повседневными задачами. Тем не менее, для полного понимания этого понятия необходимо обратиться к математическому аппарату и основным принципам, которые лежат в его основе.

В математике информация определяется как набор данных, который содержит определенный смысл или значение. Она является неотъемлемой частью теории вероятности и статистики, а также теории алгоритмов и вычислений. Одним из ключевых понятий, связанных с информацией, является понятие энтропии, которая измеряет степень неопределенности информации.

Основной принцип информации – это принцип минимальной длины описания. Согласно этому принципу, наиболее эффективное описание информации является самым коротким и наиболее точно передает суть данных. Также существуют принципы кодирования информации, которые позволяют упростить и сжать передаваемые данные, например, с помощью кодов Хаффмана или Шеннона.

«Информация – это не просто набор цифр и букв, она представляет собой мощный инструмент, который позволяет описывать и понимать мир вокруг нас. Математика играет ключевую роль в этом процессе, обеспечивая нам аппарат для анализа и обработки информации.»

В данной статье мы рассмотрим основные понятия и принципы информации в математике, а также ее роль в различных областях нашей жизни. Будут рассмотрены такие вопросы, как определение информации, ее измерение и передача, а также принципы ее кодирования. Понимание этих основных понятий поможет нам лучше разобраться в сути и значимости информации в нашей современной информационной эпохе.

Основные понятия и принципы информации в математике

ПонятиеОписание

| Дискретность | Информация может быть представлена в дискретной форме, состоящей из отдельных элементов или символов. Это позволяет ее более эффективно обрабатывать и передавать. |

| Кодирование | Для передачи информации необходимо использовать специальные коды, которые преобразуют данные в форму, понятную для системы передачи или хранения. |

| Емкость | Емкость информации определяет количество данных, которые можно передать или хранить в определенной системе. Она измеряется в битах или других единицах измерения. |

| Структура | Информация может иметь определенную структуру, которая позволяет организовать данные и обеспечить их более эффективное использование. |

| Алгоритмы | Для обработки информации используются алгоритмы, которые определяют последовательность шагов для выполнения определенной задачи. |

| Информационная энтропия | Информационная энтропия измеряет степень неопределенности или неожиданности информации. Чем больше энтропия, тем больше информации содержится в системе. |

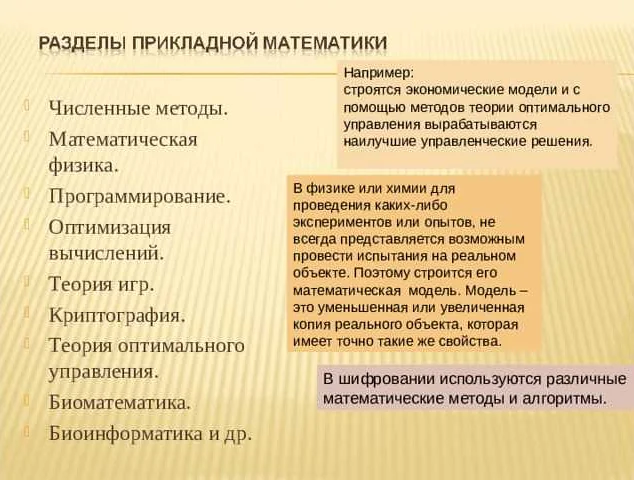

Эти основные понятия и принципы информации в математике играют важную роль в различных областях, включая теорию информации, криптографию, компьютерные науки и теорию вероятностей.

Видео по теме:

Понятие информации в математике

Информация может быть представлена численно с помощью понятия энтропии. Энтропия измеряет степень неопределенности передачи информации и является функцией вероятностей различных исходов события. Чем больше энтропия, тем больше информации несет событие или сообщение.

В теории информации также используются понятия кодирования и декодирования, которые позволяют передавать и получать информацию с использованием определенных правил и алгоритмов. Кодирование позволяет сжимать информацию, уменьшая ее объем без потери существенной информации, а декодирование восстанавливает исходные данные.

Понятие информации в математике имеет применение во многих областях, включая теорию вероятностей, криптографию, компьютерные науки и статистику. Понимание информации и ее измерение помогает разрабатывать эффективные методы передачи, хранения и обработки данных.

Математический анализ информации

В математическом анализе информации основное внимание уделяется изучению свойств информации, ее хранению и передаче, а также методам обработки и анализа данных. Эта область математики является основой для разработки и применения различных методов и алгоритмов в сферах статистики, криптографии, машинного обучения и других дисциплин.

Одной из важных задач в математическом анализе информации является оценка информационной энтропии. Энтропия – это мера неопределенности информации. Чем больше энтропия, тем больше информации содержится в системе. Математический анализ энтропии позволяет определить оптимальные методы сжатия и передачи информации.

Кроме того, в математическом анализе информации используются методы теории вероятностей и статистики. С их помощью можно анализировать случайные процессы, строить модели для прогнозирования и принимать решения на основе имеющейся информации.

Математический анализ информации играет важную роль в современном мире, где информация стала основным ресурсом и ключевым фактором успеха в различных сферах деятельности. Он помогает улучшить качество обработки данных, повысить эффективность процессов принятия решений и разработки новых технологий.

Вопрос-ответ:

Что такое информация в математике?

В математике информация — это количественное представление о данных, фактах или знаниях. Это может быть числовое значение, график, таблица или любая другая форма представления данных.

Как можно измерить информацию в математике?

Измерение информации в математике осуществляется с помощью понятия информационной энтропии. Энтропия показывает, насколько неопределенность результата эксперимента или события. Чем выше энтропия, тем больше информации содержится в результате.

Какие основные принципы связаны с информацией в математике?

Один из основных принципов, связанных с информацией в математике, — это принцип минимальной энтропии или принцип максимальной информации. Он утверждает, что наиболее информативный результат имеет наибольшую энтропию, то есть наибольшую неопределенность.

Как информация связана с теорией вероятностей в математике?

Информация тесно связана с теорией вероятностей в математике. Вероятность события может быть использована для измерения информации, содержащейся в этом событии. Чем меньше вероятность события, тем больше информации содержится в его наступлении.

Информационная энтропия

Основной концепцией информационной энтропии является идея, что более вероятные события не несут с собой много информации, в то время как менее вероятные события содержат больше информации.

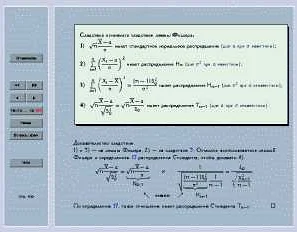

Формально, информационная энтропия H события A определяется следующим образом:

H(A) = -∑P(x)log2P(x)

где P(x) — вероятность события x.

Информационная энтропия измеряется в битах и может быть интерпретирована как количество битов, необходимых для передачи информации о событии.

Информационная энтропия имеет несколько важных свойств:

- Если все события равновероятны, то информационная энтропия будет максимальной.

- Если одно событие имеет вероятность 1, а остальные события имеют вероятность 0, то информационная энтропия будет равна 0.

- Информационная энтропия неотрицательна.

Информационная энтропия является важным понятием в теории информации и находит применение в различных областях, таких как компьютерная наука, статистика, криптография и другие.

Информационная емкость

В математике информационная емкость измеряется в битах. Бит (binary digit) — это наименьшая единица информации, которая может принимать два значения: 0 или 1. Один бит может кодировать одно двоичное число, одну букву или один символ.

Информационная емкость зависит от количества возможных состояний или символов, которые могут быть закодированы. Чем больше возможных символов, тем больше информации может быть закодировано.

Для измерения информационной емкости можно использовать таблицу, в которой указывается количество бит, необходимых для кодирования каждого символа или состояния. Такая таблица называется таблицей кодирования.

СимволБиты

| А | 01000001 |

| Б | 01000010 |

| В | 01000011 |

| Г | 01000100 |

| Д | 01000101 |

В данной таблице каждому символу сопоставлен определенный битовый код. Таким образом, для кодирования символа «А» потребуется 8 бит, а для кодирования символа «Б» — также 8 бит. Общая информационная емкость данной таблицы будет равна сумме битов для каждого символа.

Информационная емкость играет важную роль в области передачи, хранения и обработки информации, так как позволяет оптимизировать использование ресурсов и повысить эффективность системы.

Информационная структура

Информационная структура в математике определяет способ организации данных и их взаимосвязи. Это понятие играет важную роль в обработке и передаче информации.

Одной из основных информационных структур является последовательность. Последовательность — это набор элементов, упорядоченных в определенном порядке. Каждый элемент последовательности имеет свой индекс, который определяет его положение в последовательности. Например, последовательность натуральных чисел {1, 2, 3, 4, 5} имеет элементы с индексами от 1 до 5.

Другой важной информационной структурой является множество. Множество — это совокупность различных элементов, которые неупорядочены и не могут повторяться. Элементы множества могут быть разного типа, например, числа, буквы, символы и т.д. Множество обозначается фигурными скобками, например, {1, 2, 3}.

Графы — еще одна важная информационная структура в математике. Граф — это набор вершин, связанных ребрами. Вершины представляют собой объекты или сущности, а ребра — связи между ними. Графы широко используются для моделирования различных систем и отношений.

Информационная структура помогает организовать данные и позволяет проводить различные операции с ними, такие как поиск, сортировка и фильтрация. Понимание основных понятий и принципов информационной структуры в математике является важным для разработки эффективных алгоритмов обработки информации.

Принципы информационной теории

- Принцип независимости: информация о событиях должна быть независима друг от друга. Это означает, что информация, полученная из одного события, не должна влиять на информацию, полученную из другого события. Непредсказуемые события содержат больше информации, чем предсказуемые.

- Принцип единства: информация должна быть представлена одним источником. Если информация поступает из разных источников, она должна быть объединена в одну общую информацию для удобства анализа.

- Принцип минимизации: информация должна быть представлена с минимальными затратами. Это означает, что количество информации должно быть минимальным для передачи необходимых данных. Ненужная информация может привести к избыточности и потере эффективности системы.

- Принцип переносимости: информация должна быть переносимой и доступной в разных системах и форматах. Это позволяет эффективно обмениваться информацией между различными устройствами и программами.

- Принцип сохранения: информация должна сохраняться без потери искажений. Это означает, что системы хранения информации должны быть надежными и обеспечивать сохранность данных в течение длительного времени.

Принципы информационной теории являются основой для разработки эффективных информационных систем и алгоритмов. Их применение позволяет улучшить передачу, хранение и обработку информации, что имеет большое значение в современном мире, где информация является одним из основных ресурсов.

Связь информации и вероятности

В информационной теории, информация и вероятность имеют тесную связь. Информация может быть рассмотрена как мера неопределенности или неожиданности определенного события. Чем менее вероятно наступление события, тем больше информации связано с его возникновением.

Вероятность является мерой возможности наступления события, а информация о событии может быть рассчитана как обратная величина вероятности. Если событие очень вероятно, то информации о нем мало. Напротив, если событие имеет низкую вероятность, то информации о нем много.

Информация может быть измерена в битах. Бит — это единица информации, которая означает одну двоичную цифру, 0 или 1. Если событие имеет вероятность 1/2 (т.е. 50% возможности наступления), то оно содержит 1 бит информации. Если вероятность события уменьшается до 1/4, информация увеличивается до 2 битов, а если вероятность становится 1/8, информация составляет уже 3 бита.

Связь информации и вероятности позволяет измерять количество информации, содержащейся в некотором наборе данных или сообщении. Это важно для эффективной передачи и хранения информации. Например, сжатие данных основано на удалении избыточной информации и уменьшении вероятности наступления определенных событий.

Информация и вероятность также связаны с понятием энтропии. Энтропия является мерой неопределенности некоторой случайной величины. Чем выше энтропия, тем больше информации содержится в ней. Вероятность и энтропия тесно связаны, и позволяют оценить количество информации, необходимое для описания случайной величины.

Таким образом, связь информации и вероятности играет важную роль в информационной теории и математике, позволяя измерять и анализировать количество информации и оценивать неопределенность событий.

Применение информации в математике и других областях

В математике информация используется для решения различных задач. Например, информация может быть представлена в виде числовых данных, которые обрабатываются с использованием математических методов и моделей. Отсюда следует, что информация является основой для проведения математических исследований и разработки новых теорий и методов.

Однако математика — не единственная область, где информация играет важную роль. В современном мире информация является ценным ресурсом и используется во многих сферах деятельности. Например, в информационных технологиях информация используется для передачи и хранения данных. В экономике информация является основой для принятия решений и проведения анализа. В науке информация используется для обмена знаниями и проведения исследований.

Кроме того, информация играет важную роль в повседневной жизни. Например, мы используем информацию для принятия решений, планирования и организации своей жизни. Мы получаем информацию из различных источников, таких как книги, Интернет, СМИ, и используем ее для образования, развития и развлечения.

Таким образом, информация имеет широкое применение как в математике, так и в других областях знаний. Она позволяет нам описывать и анализировать структуры и отношения, решать задачи, принимать решения и развивать новые теории и методы. Информация является неотъемлемой частью современной жизни и играет важную роль в различных сферах деятельности.

Очень интересная и познавательная статья! Я всегда задавалась вопросом, что такое информация и как она связана с математикой. Автор подробно разъяснил основные понятия и принципы информации, что помогло мне лучше понять это понятие. Оказывается, информация — это не просто совокупность данных, а сущность, которая может быть измерена и обработана. Кроме того, автор объяснил разницу между алгебраическим и статистическим подходами к информации, что очень интересно. Теперь я понимаю, что информация является неотъемлемой частью математики и имеет широкое применение в различных областях. Спасибо за увлекательную статью!