Использование GPU в Python: процесс и преимущества

Содержимое

- 1 Использование GPU в Python: процесс и преимущества

- 1.1 Основы вычислительной мощности

- 1.2 Видео по теме:

- 1.3 Проблемы вычислительного процесса

- 1.4 Причины выбора GPU

- 1.5 Использование библиотеки Pytorch

- 1.6 Установка Tensorflow на GPU

- 1.7 Пример использования Numba для ускорения вычислений

- 1.8 Производительность numpy на GPU с помощью CuPy

- 1.9 Обучение нейронной сети на GPU

- 1.10 Нагрузочное тестирование на GPU

- 1.11 Решение проблем с вычислениями на GPU

- 1.12 Резюме и выводы

- 1.13 Вопрос-ответ:

- 1.13.0.1 Каким образом GPU ускоряет вычисления в Python?

- 1.13.0.2 Как я могу определить, поддерживает ли моя система CUDA?

- 1.13.0.3 Какой тип задач лучше всего подходит для использования на GPU?

- 1.13.0.4 Как нужно настроить свою машину, чтобы использовать GPU?

- 1.13.0.5 Можно ли использовать GPU, чтобы ускорить обработку видео?

- 1.13.0.6 Как много ядер процессора в моей видеокарте?

- 1.13.0.7 Может ли использование GPU значительно ускорить мою программу?

Узнайте, как максимально эффективно использовать мощности своей графической карты для вычислений в Python. Освойте ряд библиотек и инструментов, которые помогут ускорить выполнение тяжелых вычислительных задач и повысить производительность вашего проекта.

Python является одним из самых популярных языков программирования, используемых для научных вычислений. Однако, при работе с более сложными задачами, время выполнения может значительно увеличиваться в зависимости от объема данных и количества операций. В таких случаях, вычисления на центральном процессоре (CPU) могут оказаться недостаточно эффективными.

В этом случае можно воспользоваться графическим процессором (GPU) для ускорения вычислений. GPU специализируется на параллельной обработке больших объемов данных, поэтому многие задачи, требующие большого числа операций, могут быть выполнены быстрее на GPU, чем на CPU.

Для выполнения вычислений на GPU в Python можно использовать различные библиотеки и фреймворки, такие как TensorFlow, Theano, PyTorch, CNTK и другие. Каждый из этих инструментов имеет свои особенности и возможности, поэтому выбор наиболее подходящего для конкретной задачи фреймворка может оказаться важным фактором для достижения максимальной производительности.

Основы вычислительной мощности

В современном мире вычислительная мощность является одним из важнейших ресурсов. От неё зависят скорость работы программ и решение сложных задач в различных областях. Существуют различные способы увеличения вычислительной мощности, одним из которых является использование графических процессоров.

Графический процессор, или GPU, это устройство, которое предназначено для выполнения задач, связанных с обработкой графики. Однако, благодаря своей особенной архитектуре, GPU может также использоваться для выполнения других вычислительных задач.

Основное отличие между GPU и центральным процессором (CPU) заключается в том, что GPU имеет очень большое количество ядер, что позволяет ему выполнять большое количество задач параллельно. Это особенно полезно при работе с большими объёмами данных или при выполнении сложных вычислительных задач.

Современные видеокарты обычно имеют несколько тысяч ядер, что создаёт огромный потенциал для использования GPU в вычислительных задачах. Например, Python поддерживает библиотеку CUDA, которая позволяет использовать GPU для ускорения выполнения задач.

Однако, использование GPU для выполнения вычислительных задач также имеет свои ограничения. Во-первых, не все задачи пригодны для выполнения на GPU, в некоторых случаях CPU может оказаться более эффективным. Кроме того, необходимо знать, как правильно разбивать задачи для выполнения на GPU и как оптимизировать код, чтобы он работал максимально эффективно.

- Выводы:

- Графический процессор – это устройство, которое может использоваться для выполнения вычислительных задач.

- GPU имеет множество ядер, что позволяет ему выполнять параллельно большое количество задач.

- Python поддерживает библиотеку CUDA, которая позволяет использовать GPU для ускорения выполнения задач.

- Использование GPU имеет свои ограничения и требует определенных знаний для оптимизации кода и выбора задач.

Видео по теме:

Проблемы вычислительного процесса

Вычисления имеют ресурсоемкий характер, а это значит, что с увеличением объема данных, которые необходимо обработать, вычислительный процесс замедляется. Именно эту проблему и решают графические процессоры, которые позволяют параллельно обрабатывать большие объемы данных и значительно ускорить процесс вычислений.

Однако, не все алгоритмы и задачи могут быть оптимально выполнены на GPU. Некоторые задачи может быть трудно распараллелить, а в некоторых случаях возможны проблемы с достаточным объемом памяти на видеокарте для обработки большого объема данных.

Кроме того, не всегда возможно найти готовое решение для реализации вычислительного процесса на GPU, что может потребовать дополнительных усилий и знаний в области программирования и оптимизации задач на графических процессорах.

В целом, использование GPU для ускорения вычислительных процессов может привести к значительному ускорению работы программ и повышению эффективности обработки данных, но требует особого подхода и оптимизации для каждой конкретной задачи.

Причины выбора GPU

При работе с вычислительными задачами, которые требуют большого объема данных и сложных операций, использование центрального процессора (CPU) может стать значительным ограничением. В этом случае, выбор графического процессора (GPU) может стать отличным решением.

Существует несколько причин, по которым GPU может быть предпочтительнее CPU:

- Высокая параллельность – графический процессор состоит из большого количества маленьких ядер, каждое из которых может обрабатывать свою задачу параллельно с другими ядрами. Это возможно благодаря специально разработанной архитектуре GPU и способности обрабатывать большой объем данных одновременно.

- Большая вычислительная мощность – графический процессор типично снабжен большим количеством ядер, что обеспечивает гораздо большую вычислительную мощность по сравнению с центральным процессором.

- Специализированные операции – многие операции в вычислительных задачах встречаются очень часто, например, матричные операции. Графический процессор предлагает особенно эффективный способ выполнения таких операций, чем центральный процессор.

- Оптимизированный стек программного обеспечения – существует множество библиотек и фреймворков, которые были оптимизированы для работы на GPU, такие как TensorFlow или PyTorch. Используя эти библиотеки, можно значительно ускорить вычислительные задачи.

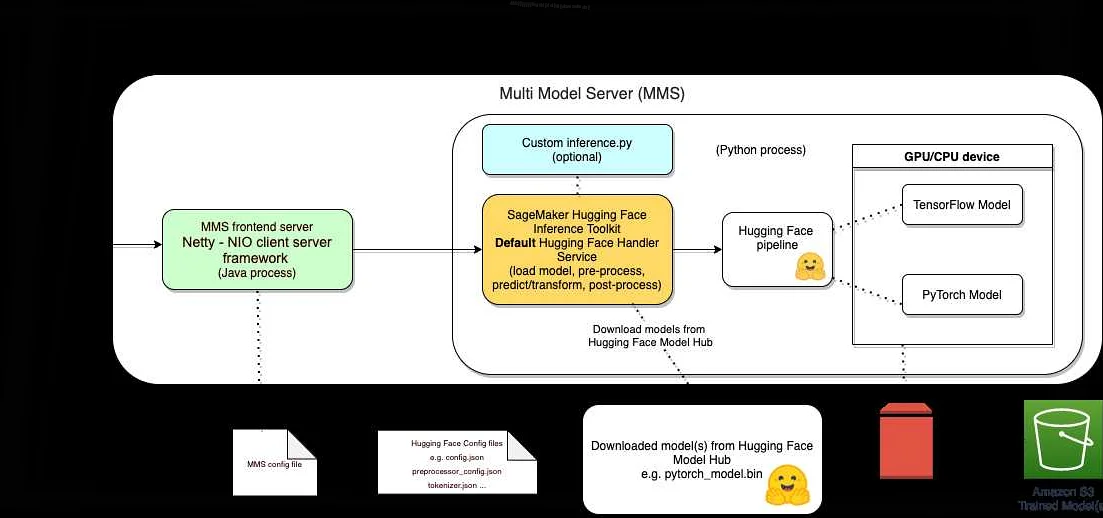

Использование библиотеки Pytorch

Pytorch — это библиотека Python для машинного обучения, которая улучшает производительность и облегчает написание кода для нейронных сетей. Она основана на языке программирования Python и предоставляет удобный интерфейс для создания нейронных сетей и их обучения с помощью графического процессора (GPU).

Для использования Pytorch необходимо установить его с помощью менеджера пакетов, например, pip. После установки библиотеки можно интегрировать ее в свой проект и начать создавать и обучать нейронные сети.

Pytorch предоставляет множество удобных инструментов для работы с данными, включая возможность генерации случайных чисел, аугментацию данных, различные функции потерь, методы оптимизации и многое другое. Одним из преимуществ Pytorch является возможность автоматического дифференцирования, что позволяет создавать более сложные модели и ускоряет процесс обучения.

Важно отметить, что для эффективного использования GPU необходимо оптимизировать код и выбирать правильные гиперпараметры — это может дать существенный прирост производительности. Также стоит учитывать, что обучение нейронных сетей на GPU может быть затратным процессом, поэтому стоит обращать внимание на стоимость использования GPU ресурсов в облаке.

В целом, Pytorch является мощным инструментом для создания и обучения нейронных сетей, позволяющим ускорить процесс вычисления благодаря использованию GPU. Она хорошо подходит для решения задач обработки изображений, распознавания речи, анализа текста и многих других задач машинного обучения.

Установка Tensorflow на GPU

Tensorflow – это открытое программное обеспечение, которое используется для глубокого обучения и машинного обучения. Для ускорения вычислений Tensorflow можно установить на графический процессор (GPU).

Для начала, необходимо убедиться в том, что на компьютере установлены необходимые драйверы для работы с GPU. Далее, нужно установить CUDA Toolkit и cuDNN. Оба инструмента необходимы для работы с Tensorflow на GPU.

После установки необходимых инструментов можно приступить к установке Tensorflow. Для этого необходимо открыть терминал и ввести следующую команду:

- pip install tensorflow-gpu

Если все драйверы установлены правильно, то Tensorflow будет установлен на GPU вместо CPU.

Чтобы проверить, правильно ли установилась версия Tensorflow, можно запустить следующую команду в терминале:

- python -c «import tensorflow as tf; print(tf.reduce_sum(tf.random.normal([1000, 1000])))»

Если выводится версия Tensorflow и результат вычислений, то это означает, что все установлено правильно.

Пример использования Numba для ускорения вычислений

Одним из наиболее популярных инструментов для ускорения вычислений в Python является библиотека Numba. Она позволяет компилировать функции Python для выполнения на графических процессорах (GPU) или центральном процессоре (CPU) с использованием JIT-компиляции.

Одним из примеров использования Numba может быть ускорение вычисления суммы элементов вектора. Например, рассмотрим следующий Python-код:

- import numpy as np

- def sum_vector(x):

- return np.sum(x)

Этот код просто вычисляет сумму элементов вектора x, используя функцию np.sum из библиотеки NumPy. Однако, если вектор x имеет большой размер, вычисление может занять много времени.

Чтобы ускорить эту операцию с помощью Numba, можно внести некоторые изменения в исходный код:

- import numpy as np

- from numba import jit

- @jit(nopython=True)

- def sum_vector(x):

- sum = 0

- for i in range(x.shape[0]):

- sum += x[i]

- return sum

Ключевым изменением является декоратор @jit, который указывает Numba на необходимость скомпилировать функцию для более быстрого выполнения. Кроме того, мы заменили вызов np.sum на цикл for, который может быть оптимизирован для более быстрого выполнения на GPU или CPU.

Теперь мы можем вызвать нашу функцию sum_vector с любым вектором и получить результат в несколько раз быстрее:

- x = np.random.rand(10000000)

- print(sum_vector(x))

Однако, следует заметить, что оптимизация с помощью Numba не всегда дает значительный прирост производительности. В некоторых случаях, например, если код уже оптимизирован или не выполняется достаточно долго, использование Numba может быть нецелесообразным. Однако, в целом, библиотека Numba является полезным инструментом для ускорения вычислений в Python.

Производительность numpy на GPU с помощью CuPy

В Python библиотека numpy является одним из наиболее популярных инструментов для работы с числами и массивами. Однако, вычисления на CPU могут быть медленными на больших объемах данных. В таких случаях, использование GPU для ускорения вычислений может быть очень полезно.

CuPy — это библиотека Python, которая расширяет numpy, позволяя использовать GPU для выполнения вычислений. Она обеспечивает максимальную совместимость с numpy, что позволяет переносить уже имеющийся код на GPU с помощью нескольких изменений в вызове функций.

Часто, использование CuPy может значительно ускорить работу вашей программы. Например, если у вас есть большой массив чисел, и вы хотите выполнить операции умножения, сложения или другие операции матричного умножения, то использование CuPy может существенно ускорить вычисления, не смотря на то, что на CPU это занимает много времени.

Если вы хотите использовать GPU для работы с numpy, вы можете начать с установки CuPy с помощью pip:

!pip install cupy

После установки, вы можете перенести код на GPU, вызывая функции numpy с CuPy-arrays.

Обучение нейронной сети на GPU

Обучение нейронных сетей является вычислительно интенсивной задачей, поэтому для достижения оптимальной скорости работы часто применяется использование графических процессоров (GPU). Использование GPU для обучения нейронных сетей может значительно ускорить процесс обучения и существенно сократить время расчетов.

Для проведения обучения нейронной сети на GPU можно воспользоваться различными библиотеками для машинного обучения, такими как TensorFlow, PyTorch или Keras. Эти библиотеки предоставляют возможность использования вычислительной мощности GPU для проведения вычислений при обучении нейронной сети.

Применение GPU для обучения нейронной сети также позволяет увеличить размеры моделей и обрабатывать более сложные данные в реальном времени. Более того, использование GPU позволяет эффективно использовать ресурсы компьютера и сократить временные затраты на проведение вычислений.

Итак, использование GPU для обучения нейронной сети является важным фактором в достижении оптимальной скорости работы модели и снижении временных затрат на проведение вычислений. Переход на использование GPU может позволить увеличить масштаб модели и обрабатывать большие объемы данных в реальном времени, что в свою очередь может привести к увеличению эффективности работы модели и повышению качества итоговых результатов.

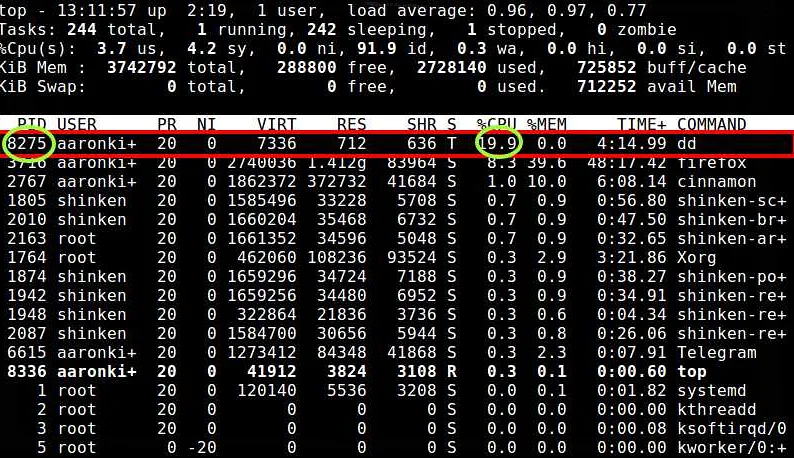

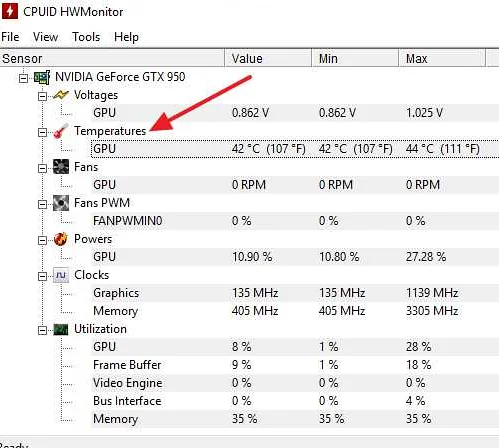

Нагрузочное тестирование на GPU

Перед началом использования GPU для вычислений следует произвести нагрузочное тестирование, которое позволит определить максимальную загрузку GPU при работе с конкретным алгоритмом и выбрать оптимальные параметры работы. Нагрузочное тестирование поможет избежать проблем с нагревом и обеспечить стабильную работу GPU.

Для нагрузочного тестирования можно использовать специальные программы, такие как FurMark, MSI Kombustor или OCCT. Они позволят узнать, сколько времени GPU может работать на максимальной нагрузке без перегрева и в каких условиях это достигается. При тестировании необходимо следить за показателями температуры и использования памяти.

Нагрузочное тестирование на GPU поможет определить, какие задачи можно решать на GPU и какие параметры выбрать для максимальной эффективности работы. Например, для расчетов в научных проектах можно выбрать GPU с высокой производительностью, а для игр — с большим количеством видеопамяти.

Однако, не следует забывать, что нагрузочное тестирование может привести к повреждению GPU, поэтому необходимо производить его с осторожностью и не на длительное время. Лучше всего проводить тестирование несколько раз в разное время, чтобы получить наиболее точные результаты.

Использование GPU для вычислений может значительно ускорить работу программ, однако, для получения максимальной производительности необходимо производить тестирование и выбирать оптимальные параметры работы. Это поможет избежать проблем и обеспечит стабильность при вычислениях на GPU.

Решение проблем с вычислениями на GPU

Использование GPU для ускорения вычислительных задач — это весьма эффективный способ повышения скорости работы программ, однако он не всегда безупречен. Могут возникать проблемы как в процессе подготовки к работе с GPU, так и в самом процессе вычислений.

Одной из наиболее распространенных проблем является некорректная установка или настройка CUDA (Compute Unified Device Architecture) — платформы для работы с GPU. Чтобы избежать этой проблемы, необходимо следовать инструкциям, предоставляемым производителем вашей видеокарты или использовать утилиты, такие как CUDA-Z, для проверки правильности установки и настройки.

Другая распространенная проблема — это проблемы с памятью. GPU имеют ограниченную объем памяти, которую можно использовать для работы, и недостаточность памяти может привести к снижению производительности или даже к аварийной остановке программ. Чтобы избежать этой проблемы, необходимо проектировать программы с учетом ограничений памяти GPU и использовать эффективные алгоритмы, оптимизированные для работы с ограниченным объемом памяти.

Также возможны проблемы с обработкой асинхронных задач, которые могут привести к снижению производительности GPU. Решением этой проблемы может быть оптимизация кода, компиляция с использованием специфических опций или использование асинхронных библиотек, таких как CuDNN, которые специально разработаны для работы с GPU.

Таким образом, при использовании GPU для ускорения вычислений необходимо учитывать ряд факторов, которые могут повлиять на производительность работы программы. Будьте внимательны и следуйте рекомендациям, чтобы избежать возможных проблем.

Резюме и выводы

Python является одним из самых популярных языков программирования в мире благодаря своей простоте и удобству использования. Однако, вычисления в Python могут быть довольно медленными, особенно для сложных задач. Это ограничение можно преодолеть, используя GPU (графические процессоры), которые способны обработать большой объем данных и выполнить вычисления в гораздо более быстром темпе.

В этой статье мы обсудили, как можно ускорить вычисления в Python с помощью GPU, используя библиотеки, такие как TensorFlow, PyTorch и NumPy. Мы также разобрались с работой графических процессоров, и как они могут помочь в ускорении наших вычислительных задач.

В заключение, использование GPU в Python может значительно ускорить вычисления и улучшить производительность. Это особенно полезно для сложных задач, таких как машинное обучение и обработка изображений. Если вы работаете с большими наборами данных и хотите оптимизировать свою работу, рассмотрите возможность использования GPU вместо CPU.

Вопрос-ответ:

Каким образом GPU ускоряет вычисления в Python?

GPU обладает большой вычислительной мощностью и параллельной архитектурой, что позволяет обрабатывать большие объемы данных за короткий промежуток времени. При использовании GPU вычисления разделяются на множество маленьких задач, которые выполняются одновременно на нескольких ядрах процессора, в то время как CPU работает над одной задачей за раз.

Как я могу определить, поддерживает ли моя система CUDA?

Для определения поддержки CUDA необходимо убедиться, что у вас установлены правильные GPU-драйверы и CUDA-версия. Вы можете проверить наличие драйверов и CUDA, выполнив команду «nvidia-smi» в командной строке.

Какой тип задач лучше всего подходит для использования на GPU?

GPU наиболее эффективно используется для вычислений, связанных с матричными операциями, сверточными нейронными сетями (CNN) и машинным обучением. Однако, не все задачи, которые могут быть выполнены на GPU, станут более быстрыми. Некоторые задачи слишком маленькие, чтобы оправдать затраты на переключение между CPU и GPU.

Как нужно настроить свою машину, чтобы использовать GPU?

Для использования GPU в Python необходимо установить библиотеки, такие как TensorFlow или PyTorch, которые поддерживают использование GPU для вычислений. Также необходимо убедиться, что вы установили драйверы и CUDA-версию для вашей видеокарты. В процессе написания кода следует указать использование GPU вместо CPU для выполнения вычислений.

Можно ли использовать GPU, чтобы ускорить обработку видео?

Да, GPU может быть использован для ускорения обработки видео. В частности, использование GPU может значительно сократить время, затрачиваемое на кодирование видео, декодирование видео и рендеринг 3D-моделей.

Как много ядер процессора в моей видеокарте?

Количество ядер процессора на видеокарте может варьироваться в зависимости от модели. Однако, большинство современных видеокарт содержат сотни или тысячи ядер процессора.

Может ли использование GPU значительно ускорить мою программу?

Да, использование GPU может существенно ускорить выполнение программы, если вычисления, которые выполняет программа, могут быть параллелизированы. Однако, если программа использует очень маленькие объемы данных, выигрыш от использования GPU может быть невелик.