Как выделить текст в Python: основы работы с строками

Содержимое

- 1 Как выделить текст в Python: основы работы с строками

- 1.1 Методы строки для выделения подстроки

- 1.2 Использование срезов для получения нужных символов

- 1.3 Регулярные выражения в Python

- 1.4 Получение текста из файла и его обработка

- 1.5 Извлечение информации из HTML страниц с помощью BeautifulSoup

- 1.6 Выделение ключевых слов в тексте с помощью библиотеки Natural Language Toolkit

- 1.7 Использование морфологического анализа для выделения частей речи

- 1.8 Фильтрация текста с помощью стоп-слов

- 1.9 Токенизация текста в Python

- 1.10 Примеры использования методов выделения текста в реальных приложениях

- 1.11 Выводы о том, как выбрать подходящий метод выделения текста в зависимости от задачи

- 1.12 Вопрос-ответ:

- 1.12.0.1 Какие существуют методы для выделения текста в питоне?

- 1.12.0.2 Как использовать метод split() для выделения текста?

- 1.12.0.3 Как использовать метод search() для поиска текста?

- 1.12.0.4 Как использовать метод findall() для поиска всех вхождений текста?

- 1.12.0.5 Как выделить только определенную часть текста?

- 1.12.0.6 Можно ли выделить текст по ключевым словам?

- 1.12.0.7 Как выделить текст в HTML-тегах?

- 1.13 Видео по теме:

Узнайте, как использовать методы выделения текста в языке программирования Python. Научитесь находить и извлекать нужные фрагменты текста из строковых переменных и файлов. Получите полезные советы для работы со специальными символами и регулярными выражениями. Примените эти знания для обработки данных и создания автоматизированных скриптов в Python.

Python — это язык программирования, который широко используется в решении различных задач. Один из основных вопросов, который возникает при работе с текстовыми данными в Python — это как выделить определенный текст в большой строке. В данной статье мы рассмотрим основные методы выделения текста в Python и приведем примеры использования каждого из них.

При работе с текстовыми данными в Python часто требуется выделить определенный участок текста. Для этого можно использовать регулярные выражения, методы строковых операций, методы работы со списками и многие другие инструменты. Каждый из них имеет свои особенности и преимущества, которые рассмотрим далее.

Выделение текста в Python может быть полезно при обработке логов, веб-скрейпинге, обработке текстовых документов и многих других задачах. При работе с большими объёмами данных выделение нужной информации может существенно ускорить процесс обработки и улучшить качество результата.

Методы строки для выделения подстроки

В Python есть несколько методов строки для выделения подстроки. Они могут быть полезными, когда требуется обработка текста или работа с определенными частями строки.

- find() — поиск подстроки в строке. Если подстрока найдена, возвращает индекс ее первого вхождения, иначе -1.

- index() — также ищет подстроку в строке, но если она не найдена, то вызывает исключение ValueError.

- count() — считает количество вхождений подстроки в строку.

- replace() — заменяет все вхождения подстроки на другую строку.

Для работы со строками в Python также доступны срезы (slicing). С помощью срезов можно получить определенную часть строки.

- Используйте s[start:end], чтобы получить подстроку, начинающуюся с позиции start и заканчивающуюся в позиции end (не включительно).

- Если start не указан, то по умолчанию считается 0, если end не указан, то это означает, что нужно взять срез до конца строки.

- Для получения каждого k-го символа строки используйте срез s[::k].

- Для получения обратной строки используйте срез s[::-1].

Выделение подстроки — это простые, но мощные методы для работы с текстом в Python.

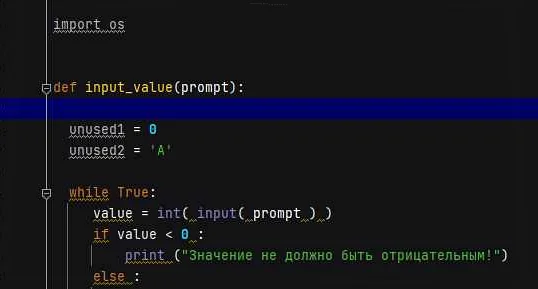

Использование срезов для получения нужных символов

В Python существует возможность использовать срезы для получения нужных символов в строке. Срезы — это способ выбрать определенную часть строки на основе ее индексов.

Для того чтобы получить символы с определенного индекса и до конца строки, можно использовать следующий синтаксис:

string[start:]

где start — это индекс начала среза, а : указывает на конец строки. Например, если у нас есть строка «Hello World», и нужно получить символы начиная с пятого пробела (индекс 5), то можно использовать следующий код:

string = «Hello World»

start = 5

substring = string[start:]

print(substring)

В результате выполнения этого кода на экран будет выведено слово «World».

Также можно использовать срезы для выбора определенного количества символов из строки. Например, если нужно получить первые три символа строки «Hello World», можно использовать следующий код:

string = «Hello World»

substring = string[:3]

print(substring)

После выполнения этого кода на экран будет выведено слово «Hel».

Удобство использования срезов заключается в том, что они позволяют быстро и просто получать нужные символы из строки без использования циклов и других сложных конструкций.

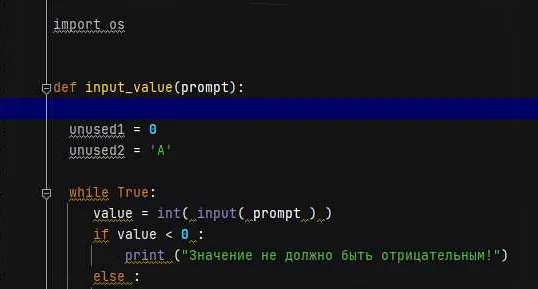

Регулярные выражения в Python

Регулярные выражения — это последовательности символов, которые определяют шаблон поиска текста в строке. Они являются мощным инструментом для работы с текстом в Python. Регулярные выражения позволяют автоматически находить и заменять определенные фрагменты текста, а также осуществлять валидацию строк.

Для работы с регулярными выражениями в Python используется модуль re. Он содержит функции для создания, компиляции и применения регулярных выражений.

Пример использования регулярных выражений в Python:

-

- Импортировать модуль re:

import re

-

- Создать регулярное выражение:

pattern = re.compile(r’text’)

-

- Применить регулярное выражение к строке:

result = pattern.findall(‘find text in this text’)

-

- Обработать результат:

print(result)

-

- Вывод: [‘text’, ‘text’]

В данном примере мы создали регулярное выражение, которое ищет слово «text» в строке. Функция findall вернула список всех найденных совпадений.

Регулярные выражения могут использоваться не только для поиска, но и для замены текста. Для этого используется функция sub. Например:

new_string = re.sub(r’text’, ‘replacement’, ‘find text in this text’)

Результат:

print(new_string)

- Вывод: «find replacement in this replacement»

Кроме того, регулярные выражения могут быть использованы для валидации входных данных. Например, проверка формата адреса электронной почты:

email = ‘example@email.com’

if re.match(r'[a-zA-Z0-9._%+-]+@[a-zA-Z0-9.-]+\.[a-zA-Z]{2,}’, email):

print(«Valid email address»)

else:

print(«Invalid email address»)

В результате выполнения этого кода вы увидите «Valid email address».

Получение текста из файла и его обработка

Для работы с текстовым файлом в питоне можно использовать несколько методов. Одним из них является функция open() для открытия файла, которую можно использовать в различных режимах, таких как чтение, запись или добавление строки в конец файла.

Для чтения текста из файла мы можем использовать метод read(). Данный метод возвращает строку, содержащую все символы, содержащиеся в файле.

Пример получения текста из файла:

with open(‘file.txt’, ‘r’) as file:

text = file.read()

Полученный текст можно обработать в зависимости от задачи. Например, можно разделить текст на отдельные слова или предложения.

Пример разделения текста на слова:

words = text.split() # разделение текста на слова

Также можно осуществить обработку текста с использованием регулярных выражений. Регулярные выражения позволяют искать и заменять определенные шаблоны в тексте.

Пример замены всех цифр в тексте на символ «*»:

import re

text = re.sub(‘\d’, ‘*’, text)

Полученный текст можно использовать для дальнейшей обработки, например, для анализа на содержание ключевых слов или для построения статистических диаграмм.

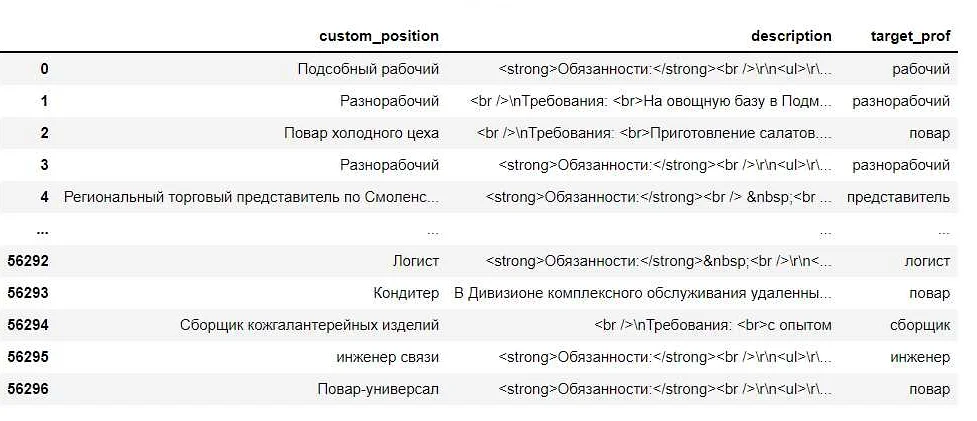

Извлечение информации из HTML страниц с помощью BeautifulSoup

BeautifulSoup – это библиотека для извлечения данных из HTML и XML документов.

Она позволяет получить доступ к элементам и атрибутам страницы и с легкостью обрабатывать данные.

BeautifulSoup доступен для установки через pip и является простым в использовании.

Для начала, необходимо импортировать библиотеку и загрузить страницу с помощью requests:

import requests

from bs4 import BeautifulSoup

page = requests.get(«https://example.com»)

soup = BeautifulSoup(page.content, ‘html.parser’)

Здесь мы импортируем requests и BeautifulSoup, затем загружаем страницу и создаем объект BeautifulSoup из содержимого страницы.

Метод content возвращает HTML страницу, которую необходимо разобрать.

Для того, чтобы извлечь информацию из страницы, необходимо знать название тега или атрибут, из которого нужно взять информацию.

Например, можно написать следующий код:

for link in soup.find_all(‘a’):

print(link.get(‘href’))

Здесь мы проходим через все ссылки на странице и выводим их URL. Метод find_all возвращает список объектов, содержащих заданный тег.

Метод get используется для извлечения значения атрибута.

Также, можно использовать метод find для поиска определенного тега или атрибута:

title = soup.find(‘title’)

print(title.get_text())

Здесь мы извлекаем заголовок страницы с помощью метода find и выводим его текст с помощью get_text.

Метод get_text извлекает текстовое содержимое элемента.

Также, BeautifulSoup позволяет обрабатывать таблицы, списки и другие элементы страницы с помощью методов, таких как find_all, find_next_sibling и других.

Используя эти методы, можно извлекать любую информацию из HTML страницы.

Выделение ключевых слов в тексте с помощью библиотеки Natural Language Toolkit

Natural Language Toolkit (NLTK) — это библиотека на языке Python для обработки естественного языка. С ее помощью можно проводить анализ текста на различные параметры, включая выделение ключевых слов.

Для начала работы с NLTK необходимо установить ее и загрузить соответствующие ресурсы. После этого можно производить обработку текста с помощью стандартных методов библиотеки.

Для выделения ключевых слов используются методы обработки текста, такие как токенизация, стемминг, лемматизация и морфологический анализ. Кроме того, можно использовать готовые инструменты для выделения ключевых слов, такие как TextRank.

TextRank — это алгоритм, основанный на PageRank, который применяется для выделения наиболее важных слов и фраз в тексте. Он использует подход, который основан на подсчете весов для каждого слова в тексте на основе его семантической связи с другими словами. Таким образом, TextRank позволяет выделять ключевые слова в тексте с высокой точностью.

В результате можно получить список ключевых слов, который можно использовать для анализа текстов и выделения основных тем и идей. NLTK позволяет проводить анализ текста на различные параметры, что делает ее незаменимой библиотекой для любого проекта по обработке естественного языка.

Использование морфологического анализа для выделения частей речи

Морфологический анализ является важным инструментом для анализа текста на естественном языке. Он позволяет определить грамматическую структуру каждого слова в предложении и выделить его части речи.

Для проведения морфологического анализа в Python используется библиотека pymorphy2. Эта библиотека позволяет с легкостью проводить морфологический анализ русского языка и выделять части речи, части слова, склонение и другие свойства слов.

Пример использования pymorphy2:

- Импортируем библиотеку:

«`python

import pymorphy2

«`

- Создаем экземпляр класса Pymorphy2:

«`python

morph = pymorphy2.MorphAnalyzer()

«`

- Выполняем морфологический анализ слова:

«`python

word = ‘стиль’

parsed_word = morph.parse(word)[0] # выбираем первый вариант разбора

print(parsed_word.tag.POS) # печатаем часть речи

«`

Результат выполнения кода:

«`python

NOUN

«`

В данном случае мы выделили часть речи слова «стиль», которая оказалась существительным (NOUN). Таким образом, применение морфологического анализа с помощью библиотеки pymorphy2 значительно упрощает выделение частей речи в тексте на естественном языке в Python.

Фильтрация текста с помощью стоп-слов

Фильтрация текста — это одно из наиболее важных заданий, которое мы решаем при работе с текстом. Важное условие при фильтрации — это удаление слов, которые не несут какой-либо смысловой нагрузки и являются часто встречающимися в тексте. Такие слова называются стоп-словами. В питоне есть несколько способов фильтрации текста при помощи стоп-слов.

Один из самых простых способов фильтрации — это использование модуля nltk, который содержит встроенные словари стоп-слов, такие как английские стоп-слова (the, a, and и т.д.).

- Сначала мы импортируем модуль nltk и загружаем список стоп-слов:

- import nltk

- nltk.download(‘stopwords’)

- from nltk.corpus import stopwords

- stop_words = set(stopwords.words(‘english’))

- Затем мы приводим наш текст к нижнему регистру и разбиваем его на отдельные слова:

- text = ‘This is a sample sentence’

- words = text.lower().split()

- Далее мы удаляем все стоп-слова из нашего списка слов:

- filtered_words = [word for word in words if word not in stop_words]

- И наконец, мы объединяем отфильтрованные слова обратно в строку:

- filtered_text = ‘ ‘.join(filtered_words)

Также можно использовать модуль spaCy, который обладает более продвинутыми инструментами для обработки текста (включая удаление стоп-слов и лемматизацию).

Удаление стоп-слов — это важный этап при работе с текстами, поскольку они не несут никакой смысловой нагрузки и могут исказить результаты анализа. Применение стоп-слов позволяет существенно улучшить качество обработки текстовых данных и их анализа.

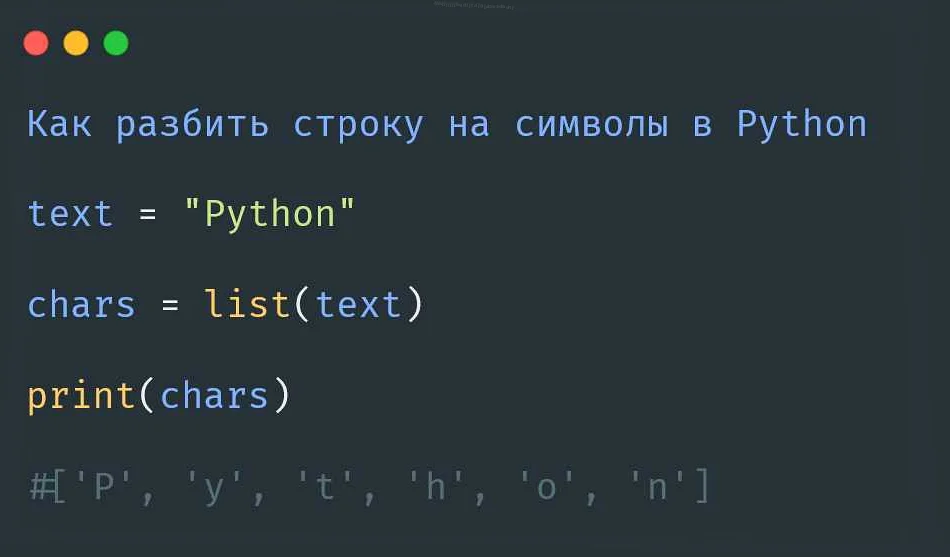

Токенизация текста в Python

Токенизация текста в Python представляет собой процесс разбиения текста на отдельные слова или элементы, называемые токенами. Токенизация является важным шагом в предварительной обработке текстовых данных в задачах обработки естественного языка.

В Python для токенизации текста часто используется модуль NLTK (Natural Language Toolkit). Он позволяет разбивать текст на токены с помощью разных методов, например, разбитие на слова (word_tokenize), на символы (char_tokenize) и на предложения (sent_tokenize).

Для разбиения на слова можно использовать метод word_tokenize, который разбивает текст на слова и знаки препинания. Также можно использовать регулярные выражения с библиотекой re для более точного разбиения на токены, учитывая особенности конкретного текста.

При работе с большими объемами данных, например, при анализе социальных сетей или новостных сайтов, токенизация текста может занять значительное время. В этом случае можно использовать модуль multiprocessing для распараллеливания процесса токенизации и ускорения работы.

Токенизация текста в Python является важным шагом в обработке текстовых данных и позволяет значительно упростить последующий анализ и обработку различных задач.

Примеры использования методов выделения текста в реальных приложениях

Методы выделения текста в питоне представляют собой мощный инструмент для работы с информацией в составе текстовых документов. Они дают возможность извлечь из большого количества текста нужные данные и автоматизировать работу с ними. Благодаря этому, методы выделения текста находят широкое применение в различных областях жизни, в том числе в информационных технологиях, науке, медицине, правительственных структурах и других.

Одним из примеров использования методов выделения текста может стать анализ данных в маркетинге. Например, при проведении исследования рынка, аналитикам необходимо провести анализ собранных данных и извлечь из них ключевые показатели, такие как количество потенциальных клиентов, интересующихся определенным продуктом или услугой. Для этого они могут использовать методы выделения текста, чтобы выделить нужную информацию из текстовой выгрузки данных.

Еще одним примером использования методов выделения текста может стать обработка клинических текстов в медицинской сфере. Например, медицинским работникам необходимо обрабатывать большие объемы медицинских записей и выявлять в них ключевые значения, такие как симптомы, диагнозы, рекомендации по лечению и т.д. Для этого может использоваться метод выделения ключевых слов, который позволяет быстро и точно извлекать нужную информацию из текстовых документов.

В целом, методы выделения текста в питоне являются важным инструментом для работы с текстовыми данными в реальных приложениях. Они позволяют быстро и точно извлекать нужную информацию из текста, что способствует повышению производительности и эффективности работы в различных отраслях экономики и науки.

Выводы о том, как выбрать подходящий метод выделения текста в зависимости от задачи

При выборе метода выделения текста в питоне необходимо учитывать цель задачи. Если нужно выделить все определенные слова в тексте, то подойдет метод поиска с помощью регулярных выражений. Если нужно выделить все слова определенной части речи, то можно воспользоваться библиотекой Natural Language Toolkit.

Кроме того, для улучшения качества выделения можно применить методы предобработки текста, такие как лемматизация и стемминг. Они позволяют уменьшить количество словоформ и свести их к основе, что упрощает процесс выделения.

Для выбора оптимального метода также нужно учитывать размеры текста, его структуру и формат (например, если нужно выделить текст из PDF-файла, то потребуется использовать специальную библиотеку).

- При выборе метода выделения текста:

- Определите цель задачи

- Используйте методы предобработки текста

- Учитывайте размеры, структуру и формат текста

Используя правильный метод выделения текста, можно существенно облегчить автоматическую обработку больших объемов данных и повысить качество анализа. Поэтому важно подходить к выбору метода с учетом конкретной задачи и не бояться экспериментировать с разными вариантами.

Вопрос-ответ:

Какие существуют методы для выделения текста в питоне?

Существуют различные методы для выделения текста в питоне, например, можно использовать метод split(), search(), findall() и т. д. Каждый из них имеет свои особенности, но все они позволяют выделить необходимую часть текста.

Как использовать метод split() для выделения текста?

Метод split() разделяет текст на части, используя определенный разделитель. Например, можно использовать следующий код: text.split(«разделитель»), где вместо «разделитель» необходимо указать символ, по которому нужно разделить текст. Этот метод возвращает список с частями текста.

Как использовать метод search() для поиска текста?

Метод search() ищет первое вхождение регулярного выражения в тексте, возвращая объект match. Например, можно использовать следующий код: re.search(«регулярное выражение», text), где вместо «регулярное выражение» нужно указать шаблон для поиска. Если в тексте не будет найдено соответствие, то вернется None.

Как использовать метод findall() для поиска всех вхождений текста?

Метод findall() ищет все вхождения регулярного выражения в тексте, возвращая список строк. Например, можно использовать следующий код: re.findall(«регулярное выражение», text), где вместо «регулярное выражение» нужно указать шаблон для поиска.

Как выделить только определенную часть текста?

Чтобы выделить только определенную часть текста, необходимо использовать срезы (slice). Например, можно использовать следующий код: text[start:end], где start — индекс первого символа, end — индекс символа, который находится после выделенной части текста.

Можно ли выделить текст по ключевым словам?

Да, можно использовать регулярные выражения для поиска ключевых слов в тексте. Например, можно использовать следующий код: re.findall(r’\bключевое_слово\b’, text), где вместо «ключевое_слово» нужно указать слово, которое хотите найти.

Как выделить текст в HTML-тегах?

Чтобы выделить текст в HTML-тегах, нужно использовать библиотеку BeautifulSoup. Например, можно использовать следующий код: soup.find(‘тег’).text, где вместо «тег» нужно указать тег, в котором находится нужный текст. Этот метод вернет текст, находящийся внутри тега.